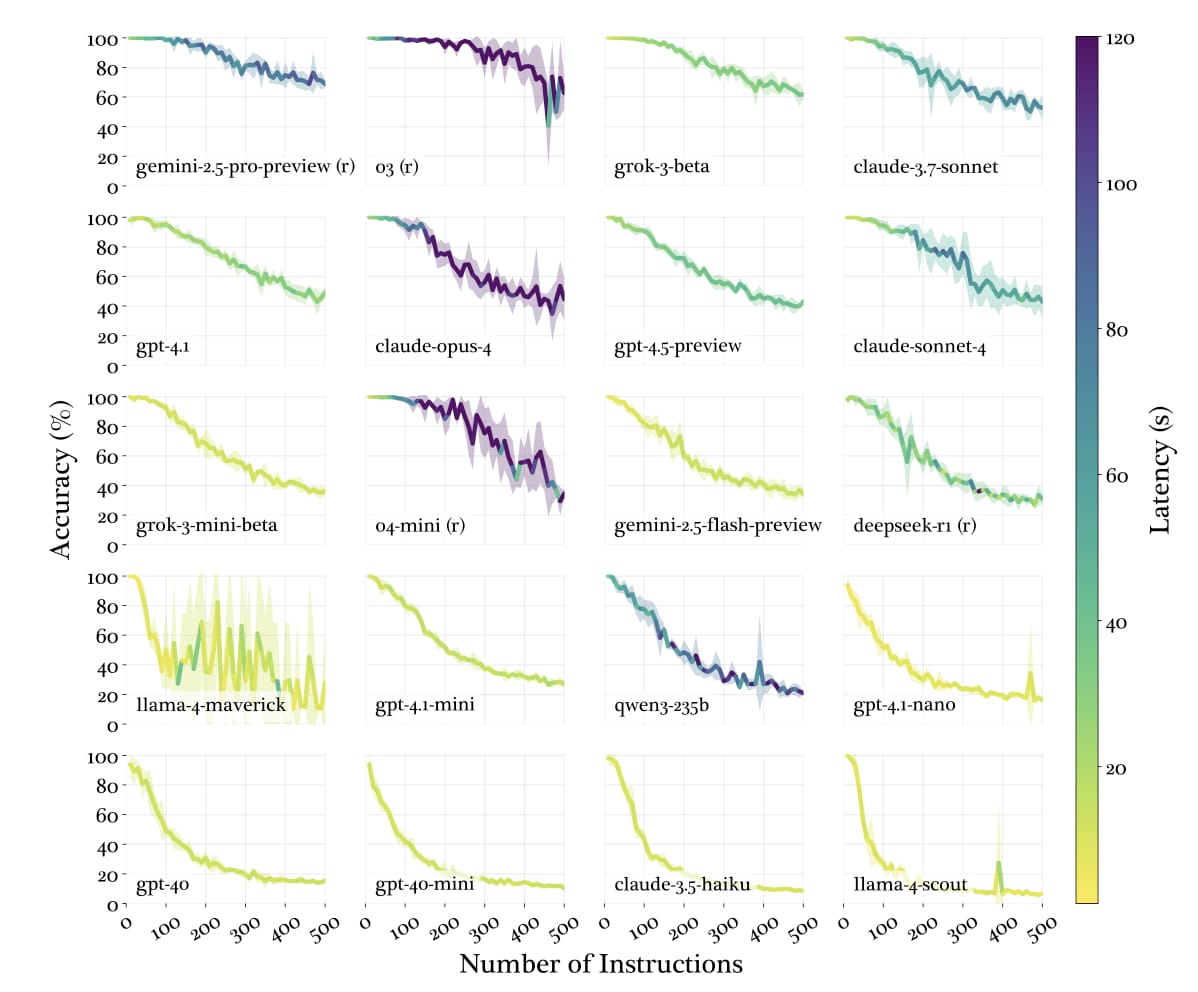

Quante istruzioni un LLM di frontiera è in grado di rispettare in un prompt? Non più di 150-200:

#ai

A volte Codex CLI è veramente stupido:

I need to inspect each file that imports '$lib/app/responses/domains-groups', but I failed due to quoting the route path incorrectly. I haven’t modified anything yet.

E si ferma.

Molti dei prodotti delle “intelligenze artificiali” di cui parliamo quotidianamente mi sembra siano finora prodotti già esistenti, che queste tecnologie ci stanno aiutando a ottenere con minor impegno e a volte con maggiore qualità di quelli che avremmo ottenuto senza quelle tecnologie (tutte le immagini che vediamo prodotte da “intelligenze artificiali” possono essere realizzate con Photoshop; dei testi celebriamo proprio quanto siano simili a quelli umani, non diversi, impensati o eccezionali; eccetera). Non vedo – in questa gran parte di esempi protagonisti delle esperienze e conversazioni quotidiane della maggioranza delle persone – produzioni di cose o funzioni nuove e prima inesistenti, né effetti nuovi di quelle produzioni che trasformino le vite degli umani (salvo che nel tempo che liberano, o nel lavoro che sottraggono). In gran parte parliamo di “contenuti”: testi, immagini, suggerimenti, insegnamenti. Insomma, al momento niente sembra paragonabile alle trasformazioni indotte nelle nostre vite, nelle nostre società, persino nelle nostre teste, dalle innovazioni degli scorsi decenni. Al momento.

Un giovane molto esperto e molto coinvolto nelle cose delle “intelligenze artificiali” mi ha messo le cose in una prospettiva interessante, pochi giorni fa: secondo lui esistono “intelligenze artificiali cattive” in quanto fanno cose al posto nostro atrofizzando in prospettiva la nostra capacità di farle e rincoglionendoci ancora di più (che le trasformazioni digitali degli scorsi decenni ci abbiano in parte rincoglionito è ormai dato per condiviso); ed esistono “intelligenze artificiali buone” che invece possiamo usare per migliorarle, le nostre capacità, e aumentare le nostre conoscenze e competenze. Mi è sembrata fin qui una lettura convincente: se ci pensate, è successo anche con la storia dell’umanità pre-digitale che i progressi tecnici e i nuovi strumenti ci sollevassero dal saper fare delle cose grazie al fatto che quelle cose le sapeva fare qualcun altro (parliamo di competenze e capacità, qui, non di rapporti di forza). E che nel frattempo i progressi civili e tecnici venissero sfruttati anche per aumentare altre conoscenze di tutti: attraverso la scuola, l’informazione giornalistica, la divulgazione, i libri, eccetera. La differenza adesso sarebbe che non avverrebbe più la seconda cosa, perché la conoscenza verrà tutta indirizzata verso i software (poi forse, dicono in molti, non ci sarà più conoscenza da indirizzare): la distribuzione di sapere tra gli umani si azzererà.

In my experience, the people who are excited about AI art also happen to be some of the most talentless fucking people I've ever met. They're middle managers, executives, or marketers whose LinkedIn bio reads: "I'm the Chief Brand Officer of User Engagement at DataRectal, but what I really am is a storyteller".

AI art is an interesting technology because despite its growing popularity, nobody seems to want it.

Matthew Inman, fumettista, in un fumetto sulle immagini/video generati con AI.

TIL Nano Banana per la generazione di immagini AI non è un diffusion model ma autoregressive, a differenza delle generazioni precedenti di Imagen e a differenza di DALL-E 2 e 3. E Midjourney e Stable Diffusion.

Of note, gpt-image-1, the technical name of the underlying image generation model, is an autoregressive model. While most image generation models are diffusion-based to reduce the amount of compute needed to train and generate from such models, gpt-image-1 works by generating tokens in the same way that ChatGPT generates the next token, then decoding them into an image. It’s extremely slow at about 30 seconds to generate each image at the highest quality (the default in ChatGPT), but it’s hard for most people to argue with free.

In August 2025, a new mysterious text-to-image model appeared on LMArena: a model code-named “nano-banana”. This model was eventually publically released by Google as Gemini 2.5 Flash Image, an image generation model that works natively with their Gemini 2.5 Flash model. Unlike Imagen 4, it is indeed autoregressive, generating 1,290 tokens per image. After Nano Banana’s popularity pushed the Gemini app to the top of the mobile App Stores, Google eventually made Nano Banana the colloquial name for the model as it’s definitely more catchy than “Gemini 2.5 Flash Image”.

"I was wrong"

Magika 1.0

Scrivevo un anno e mezzo fa:

In uno dei suoi tremila blog ieri Google ha annunciato anche un nuovo interessante progetto open source chiamato Magika. Serve a identificare il tipo di un file in automatico e si basa su un modello deep learning molto piccolo e molto efficiente, con tempi di inferenza di pochi millisecondi anche su CPU.

Finora il riconoscimento del tipo di un file era basato sul suo nome (es. estensione .pdf) o sull'analisi dei "magic byte", delle sequenze binarie presenti all'inizio dei file che in molti casi ne permettono l'identificazione. Magika è però di gran lunga superiore rispetto a queste tecniche, con le metriche precision, recall e F1 che superano il 99% e per alcuni tipi di file raggiungono il 100%.

Magika si può usare facilmente con Python o JavaScript, infatti la demo ufficiale funziona nel browser: https://google.github.io/magika/

Ora Magika ha raggiunto la 1.0:

Today, we are happy to announce the release of Magika 1.0, a first stable version that introduces new features and a host of major improvements since last announcement. Here are the highlights:

- Expanded file type support for more than 200 types (up from ~100). -A brand-new, high-performance engine rewritten from the ground up in Rust.

- A native Rust command-line client for maximum speed and security.

- Improved accuracy for challenging text-based formats like code and configuration files.

- A revamped Magika Python and TypeScript module for even easier integrations.

Prestazioni notevoli:

Magika is able to identify hundreds of files per second on a single core and easily scale to thousands per second on modern multi-core CPUs thanks to the use of the high-performance ONNX Runtime for model inference and Tokio for asynchronous parallel processing, For example, as visible in the chart below, on a MacBook Pro (M4), Magika processes nearly 1,000 files per second.

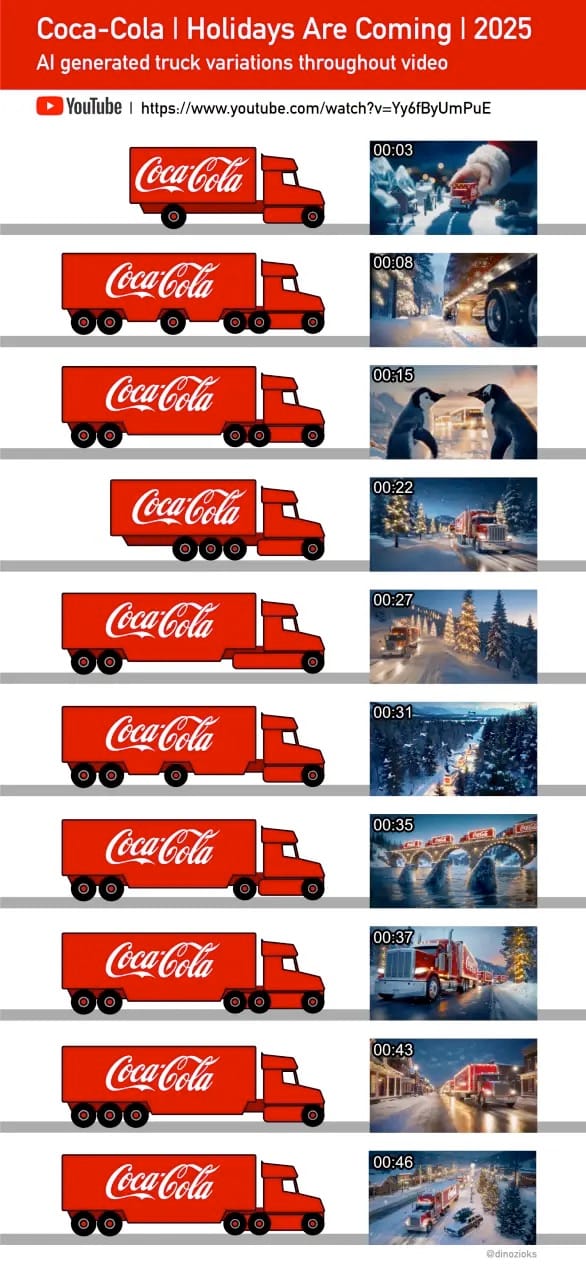

Uno spot Coca Cola mostra i limiti dell'AI generativa nei video:

Palesemente non una buona idea, eppure.

Come funziona Discover Weekly di Spotify:

Discover Weekly is far more sophisticated than the Music Genome project. It starts by pulling in songs from playlists created by its users, then matches them against a taste profile for each individual user, using technology from a company called The Echo Nest that it purchased in 2014. Then it performs additional fine-tuning and filtering, including machine learning analysis of raw audio data, before building you a unique 30-song playlist.

We’ve now seen reports of non-developers trying to use Gemma in AI Studio and ask it factual questions. We never intended this to be a consumer tool or model, or to be used this way. To prevent this confusion, access to Gemma is no longer available on AI Studio. It is still available to developers through the API.

(Google)

Can ChatGPT Land an Airplane? (video) è una delle cose più frustranti che ho mai visto. Sarà che la modalità vocale di ChatGPT è pensata per conversazioni leggere, ma sembra di parlare con GPT-3.5, cioè quando gli LLM dicevano qualsiasi cosa con convinzione, entusiasmo e nonchalance senza considerare il contesto, senza fare domande essenziali per risolvere il problema, senza mostrare un briciolo di incertezza, pianificazione, attenzione alle richieste, consapevolezza dei fondamentali, ecc. (Lo fanno ancora, ma il problema è stato in buona parte mitigato, specialmente con il reasoning.)

Interessante 0github.com:

To try it, replace github.com with 0github.com in any GitHub pull request url. Under the hood, we clone the repo into a VM, spin up gpt-5-codex for every diff, and ask it to output a JSON data structure that we parse into a colored heatmap.

AI slop

Nel caso non fosse ancora entrato nel vostro vocabolario, con AI slop si intendono contenuti di qualità medio-bassa creati con strumenti di intelligenza artificiale, secondo The Conversation. A me piace più la definizione su Wikipedia: “un contenuto digitale realizzato con l’intelligenza artificiale generativa, in particolare quando viene percepito come privo di impegno, qualità o significato profondo e caratterizzato da un volume di produzione eccessivo”.

Carola Frediani in Guerre di rete.

Admiring the implementation

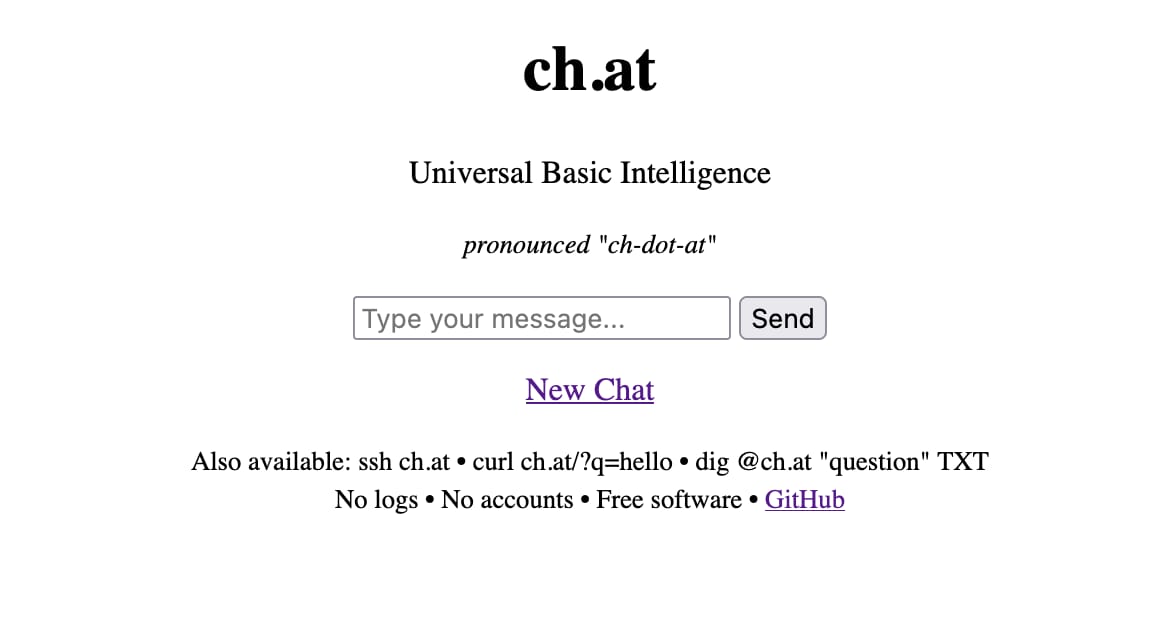

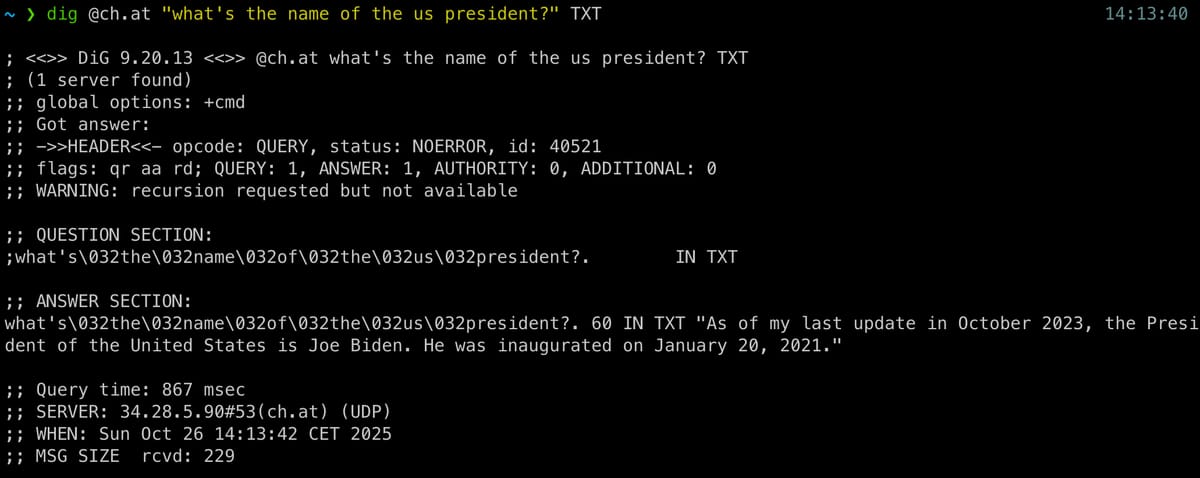

ChatGPT over DNS

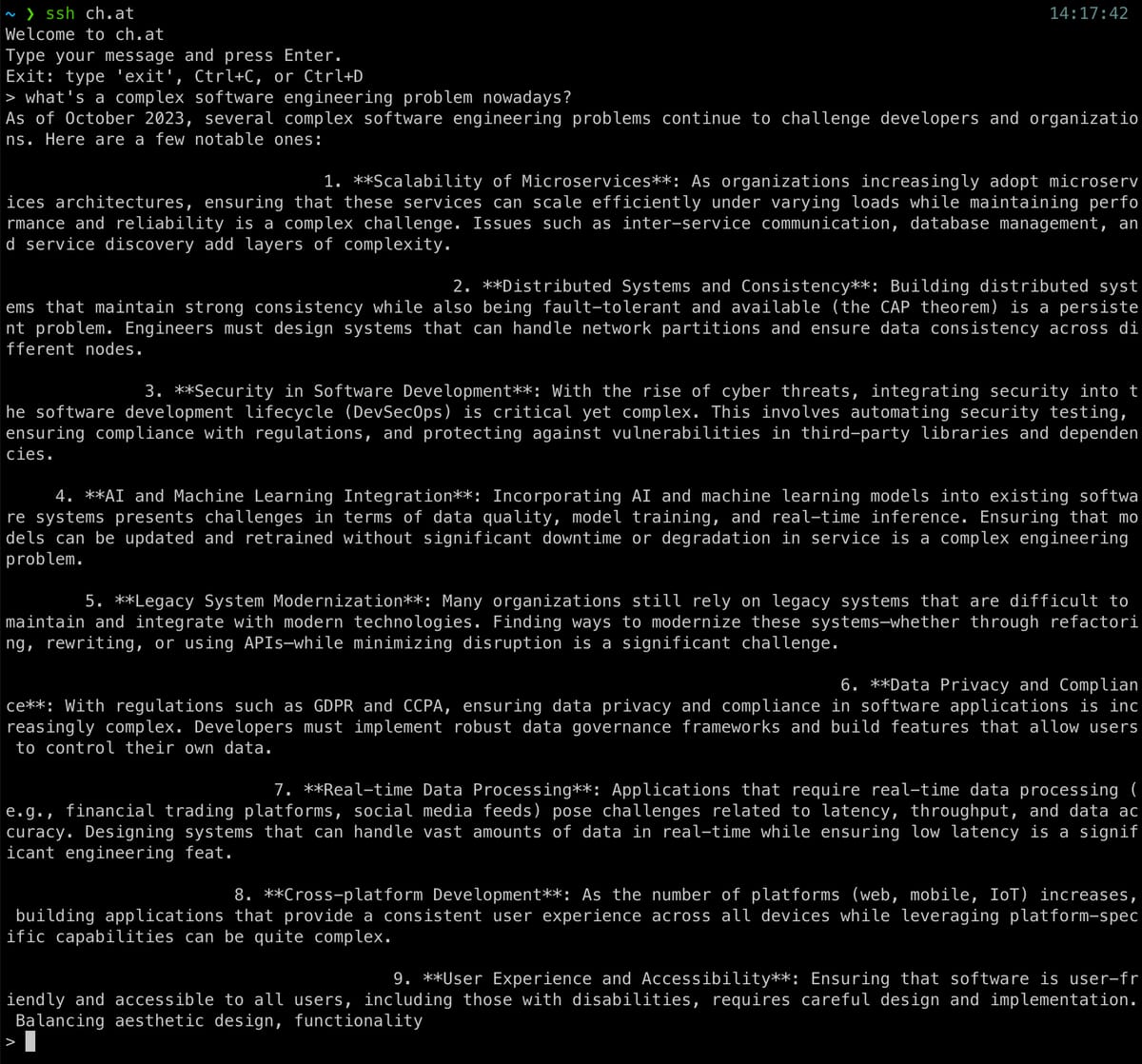

Anthropic punta sul B2B, mentre OpenAI domina il mercato di massa consumer:

Anthropic has generated much less mass-market appeal. The company has said about 80% of its revenue comes from corporate customers. Last month it said it had some 300,000 of them.

Anthropic is also surprisingly close to OpenAI when it comes to revenue. The company is already at a $7 billion annual run rate and expects to get to $9 billion by the end of the year—a big lead over its better-known rival in revenue per user.

(WSJ)

I grandi temi nell'AI negli ultimi 4 anni:

- 2022: ChatGPT

- 2023: Multimodality

- 2024: Modelli di reasoning

- 2025: Agenti e browser AI

Vedremo il 2026!

In Firefox 144 ora si può cercare un'immagine con Google Lens dal menù "tasto destro".

Archivio

Tag

- #ai (58)

- #dev (39)

- #cloud (35)

- #italia (25)

- #cdn (17)

- #digitalizzazione (17)

- #internet (16)

- #security (14)

- #cloudflare (14)

- #social (13)

- #browser (13)

- #mondo (12)

- #aws (11)

- #reti (11)

- #openai (11)

- #business (11)

- #google (10)

- #database (10)

- #video (9)

- #mobilità (8)

- #informazione (8)

- #dns (7)

- #storage (7)

- #scrivere (7)

- #macos (6)

- #pagopa (6)

- #web-dev (6)

- #meta (5)

- #bending-spoons (5)

- #open-source (5)

- #anthropic (5)

- #design (5)

- #domini (5)

- #http (5)

- #antipirateria (4)

- #github (4)

- #innovazione (4)

- #telegram (4)

- #energia (3)

- #privacy (3)

- #ovh (3)

- #microsoft (3)

- #cie (3)

- #ipv6 (3)

- #claude (3)

- #hetzner (2)

- #colori (2)

- #git (2)

- #datacenter (2)

- #android (2)

- #dataviz (2)

- #amazon (2)

- #javascript (2)

- #email (1)

- #broadcasting (1)

- #blog (1)

- #eu (1)

- #dotnet (1)

- #bandaultralarga (1)

- #codex (1)

- #akamai (1)

- #legal (1)

- #apple (1)